(圖說:OpenAI GPT-OSS 開放權重模型代表著 AI 領域從封閉走向開放混搭的重要里程碑。拍攝於 Lac de Neuchatel 湖畔,瑞士。圖片來源:Ernest。)

(圖說:OpenAI GPT-OSS 開放權重模型代表著 AI 領域從封閉走向開放混搭的重要里程碑。拍攝於 Lac de Neuchatel 湖畔,瑞士。圖片來源:Ernest。)

tl;dr 重點摘要

OpenAI 釋出了兩個 開放權重 (open-weight) 的推理導向語言模型家族:gpt-oss-120b 與 gpt-oss-20b。它們可在本地或多家雲端/第三方推論平台上執行,採 Apache-2.0 授權並搭配一份額外的 使用政策 (usage policy) 1;OpenAI 強調已做過針對濫用的安全性測試。

- 性能表現:gpt-oss-120b 在數學競賽(AIME)和健康對話(HealthBench)上超越 o4-mini,在 MMLU 達到 90%;就算是這次釋出的小模型 gpt-oss-20b 也能在數學競賽上表現出色,AIME 2025 達到 98.7% 2。

- 硬體友善:透過 MXFP4 量化 技術,gpt-oss-120b 需要 80~96 GB VRAM,gpt-oss-20b 僅需 12 GB VRAM 可在消費級硬體上執行。

- 創新格式:支援 Harmony response format,一種多通道、可攜帶推理過程與工具呼叫的訊息格式。

- 完整推理:提供 Chain-of-Thought 存取權,有助於偵錯與信任建立 3。

- 生態整合:已與 Hugging Face、vLLM、Ollama、LM Studio、Amazon Bedrock、Databricks 等平台深度整合,模型與平台代管部署同步發佈 4。

- 安全保障:透過 Preparedness Framework 5 完成系統性安全測試,惡意微調版本未達高危能力門檻。

內容大綱

1. OpenAI 開源策略的重大轉向

自 2019 年 GPT-2 之後,OpenAI 一直堅持封閉模型策略,透過 API Platform 和 ChatGPT 提供服務。然而,gpt-oss 4 的釋出暗示著某種戰略轉向:從純封閉走向混合模式。(先只討論語言模型,沒有計入 Whisper, CLIP。)

1.1 背景脈絡

在開源 AI 生態系統中,Meta 的 Llama 系列 (since 2023-02)、Google 的 Gemma 系列 (since 2024-02) 已經建立了強大的開發者社群。OpenAI 可能意識到,僅依賴封閉 API 將失去某些重要的市場份額,特別是在企業對資料隱私、資料隔離要求日益嚴格的市場環境下。

GPT-OSS 的推出,讓 OpenAI 能夠:

- 擴大在開發者社群的影響力

- 滿足企業本地部署、產品地端部署的需求

- 與開源生態系統形成良性循環

- 為其主打封閉模型 (GPT-4.1、GPT-4o、o3) 建立「入門學習路線」

1.2 混合策略的商業考量

這種混合策略允許 OpenAI 在不同市場區隔之間進行差異化產品定位:

- 開放權重模型 (e.g. GPT-OSS)

- 吸引開發者、教育機構、中小企業、

- 維度單純的應用場景。

- 封閉 API 模型 (e.g. GPT-4.1、GPT-4o、o3)

- 服務大型企業、

- 需要多模態能力的應用場景。

- 專業服務:

- 針對特定產業的客製化解決方案。

所有當下可使用的 OpenAI 模型清單,請參閱官方平台說明文件:Models - OpenAI API。

2. GPT-OSS 核心技術與特色

GPT-OSS 除了是 OpenAI 模型的「開源版本」,還是專門以 推理 (reasoning) 和 代理式應用 (agentic applications) 優化的架構。

2.1 模型架構:Mixture-of-Experts (MoE)

GPT-OSS 的 Transformer 架構佐 Mixture-of-Experts 協助 6,這是一種能夠在保持高性能的同時,大幅降低推論成本的技術 :

- gpt-oss-120b

- 大規模參數配置,

- 採用 MoE 架構分散計算負載

- gpt-oss-20b

- 中等規模參數配置

- 適合更廣泛的部署場景

確切的參數數量和專家配置細節可參考 Hugging Face 模型頁面 3 7。

這種設計讓模型能夠根據輸入內容,動態選擇最相關的「專家」來處理,既保持大模型的能力,也控制計算成本。

2.2 MXFP4 量化技術

MXFP4 (Mixed-Precision 4-bit Floating Point) 是 NVIDIA 開發的新型量化格式,特別針對推論場景優化:

- 記憶體節省:相較於傳統 16-bit,記憶體需求降低約 50-75%。

- 硬體支援:在 NVIDIA Hopper (H100) 架構上原生支援。

- 精度保持:相較於整數量化,能更好地保持模型精度。

透過 MXFP4 量化技術:

- gpt-oss-120b

- VRAM 需求約 80GB,適合企業級 GPU 部署 e.g. NVIDIA Hopper (H100)。

- 在我的 Macbook Pro M4 Pro 使用 LM Studio 看到 GGUF 版本 (with MXFP4),檔案大小大約 63.39 GB。

- MLX 版本 (8-bit) 大約 124.20 GB。

- gpt-oss-20b

- VRAM 需求從理論上的 42GB 降低到實際的 16GB,使其能在消費級 GPU 上執行。

- 在我的 Macbook Pro M4 Pro 使用 LM Studio 看到 GGUF 版本 (with MXFP4),檔案大小大約 12.11 GB。

- MLX 版本 (8-bit) 大約 22.26 GB。

實際需要的記憶體 (RAM, VRAM) 依照你的環境配置會有所不同。期待更多實測結果。

2.3 Harmony Response Format

Harmony 8 是 OpenAI 為 GPT-OSS 設計的新型回應格式,嘗試解決傳統對話格式在複雜推理和工具使用場景中的不足:

<|start|>role:assistant

<|message|>

我需要分析這個問題的多個面向...

<|end|>

<|start|>role:assistant,type:reasoning

<|message|>

[Chain-of-Thought 推理過程]

讓我逐步分析:

1. 首先識別關鍵變數...

2. 然後評估各種可能性...

<|end|>

<|start|>role:assistant,type:tool_use

<|message|>

{"function_name": "python_execute", "parameters": {"code": "..."}}

<|end|>

<|start|>role:assistant

<|message|>

基於以上分析,我的結論是...

<|end|>

Harmony 的優勢:

- 通道並行:同時呈現推理、工具使用、最終回答

- 結構透明:清楚區分不同類型的模型輸出

- 除錯友善:開發者可完整檢視推理過程

2.4 Chain-of-Thought

與許多「黑盒」模型不同,GPT-OSS 提供了完整的 Chain-of-Thought 存取權。

- 透明推理:開發者可檢視模型每一步的思考過程

- 除錯能力:快速定位推理錯誤或偏差

- 信任建立:透過觀察推理過程建立對模型輸出的信心

- 學習機會:研究人員可深入理解大模型的推理模式

重要提醒:OpenAI 建議 Chain-of-Thought 不應直接展示給終端使用者,因為其中可能包含幻覺、有害內容或不當資訊 3。

2.5 工具使用與代理能力

GPT-OSS 在設計時就考慮了 Agentic AI 的需求,內建工具使用 (tool use; function calling) 能力:

- 網頁瀏覽:能夠搜尋 (web search) 和採集 (web fetch) 網路資訊

- 程式執行:原生支援 Python 程式碼執行和除錯(題外話,其他非主流訓練的程式語言建議可嘗試中間語言協助轉譯)

- 結構輸出:支援 JSON Schema 約束的輸出格式

- 多步規劃:能夠分解複雜任務並逐步執行

這邊的難處對比到人腦就是「記憶儲存」和「動手執行」是運用大腦不同區域在運作,可參考我在 COSCUP 2021 分享的 打造個人知識系統 所畫的參考圖。

3. 系統架構與生態整合

GPT-OSS 的真正價值不僅在於模型本身,從模型到部署,OpenAI 構建了一套自己的生態整合系統。

3.1 Hugging Face:模型發布與社群平台

Hugging Face 作為 GPT-OSS 的主要發布平台,提供:

- 模型下載:完整的權重檔案和配置

- 快速開始:預設的

transformers整合程式碼 - 社群討論:開發者經驗分享和問題解答

- 模型卡片:詳細的技術規格和使用指南

開發者可以使用簡單的程式碼開始:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("openai/gpt-oss-20b")

tokenizer = AutoTokenizer.from_pretrained("openai/gpt-oss-20b")

3.2 vLLM:高性能推論引擎

vLLM 是專為大型語言模型優化的推論引擎,支援 GPT-OSS:

核心優勢:

- PagedAttention:記憶體使用效率提升 4 倍

- 連續批次處理:吞吐量提升 20 倍以上

- OpenAI 相容 API:無縫替換現有整合

部署範例:

# 啟動 vLLM 服務

python -m vllm.entrypoints.openai.api_server \

--model openai/gpt-oss-20b \

--quantization MXFP4

# 使用 OpenAI 相容的 API

curl http://localhost:8000/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "openai/gpt-oss-20b",

"messages": [{"role": "user", "content": "Explain quantum computing"}]

}'

3.3 LM Studio:圖形化本地部署工具

LM Studio 是一個圖形化的本地 AI 模型管理工具,為非技術使用者提供直觀的 GPT-OSS 部署體驗:

- 視覺化模型管理:拖放式模型安裝和切換

- 內建聊天界面:無需額外程式設計即可測試模型

- 硬體自動檢測:自動識別 GPU 配置並優化性能

- 多格式支援:GGUF、GGML 等多種量化格式

之前在 Apple Silicon 比較 LM Studio 和 Ollama 跑 Gemma3 的效能,LM Studio 較佳約 26 %–30 % t/s。可以觀察一陣子 GPT-OSS 的情況。

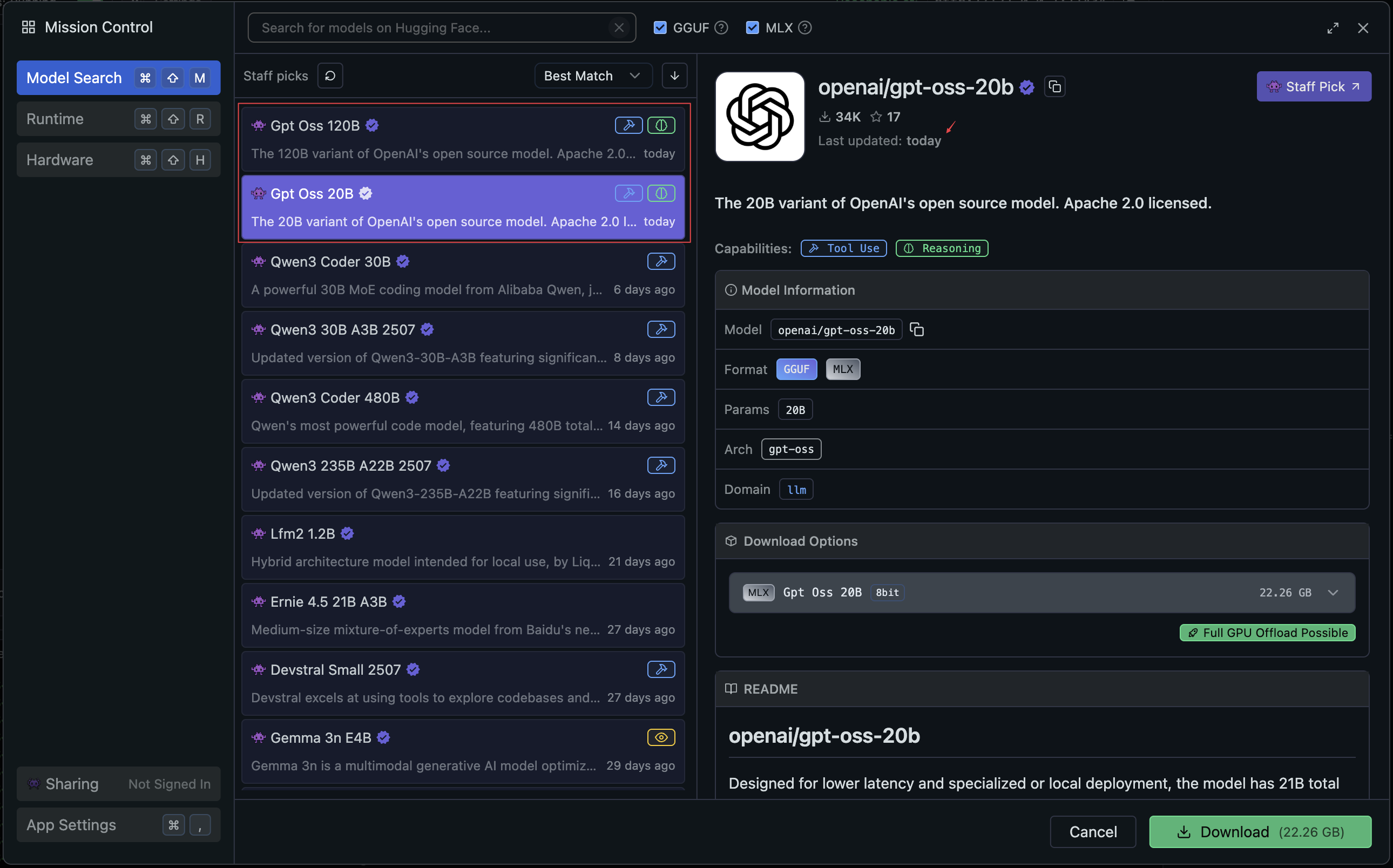

(OpenAI GPT-OSS 於 2025-08-06 凌晨發表,當天在 LM Studio 即可下載 GPT-OSS 模型。)

(OpenAI GPT-OSS 於 2025-08-06 凌晨發表,當天在 LM Studio 即可下載 GPT-OSS 模型。)

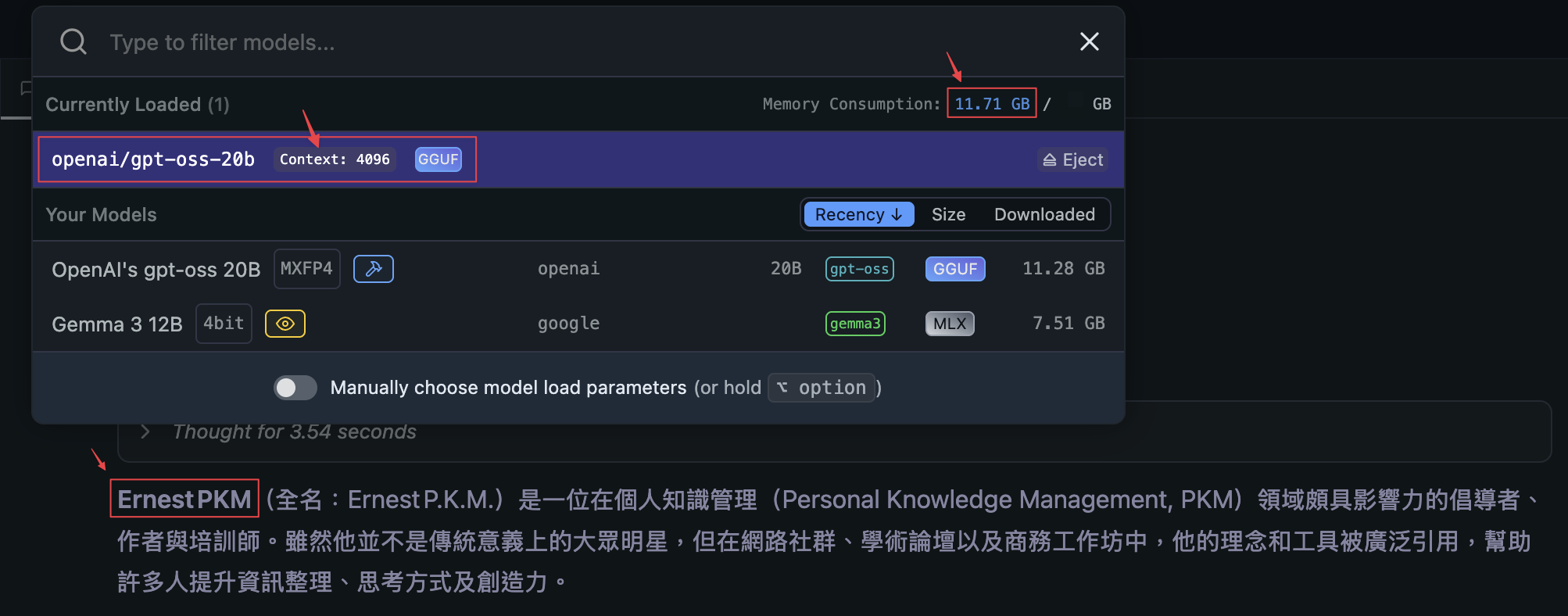

(使用 LM Studio 載入 OpenAI GPT-OSS 20B,它居然認得 Ernest PKM 概念耶!)

(使用 LM Studio 載入 OpenAI GPT-OSS 20B,它居然認得 Ernest PKM 概念耶!)

附上一段 LM Studio 執行 OpenAI GPT-OSS 20B GGUF 的結果,

- 速度很讓人滿意耶:

43.97 tok/sec • 1312 tokens • 0.40s to first token。 - 我用台灣繁體中文問它:

請推論 OpenAI 為什麼會推出 gpt-oss 這樣的開源權重模型?背後有何策略? - 它回答如下:

<|channel|>analysis<|message|>Need to explain motivations: openness, research community, trust, compliance, competition, safety, regulatory, etc. Provide strategic angle: brand, ecosystem, data collection, policy testing, etc.<|end|>

<|start|>assistant<|channel|>final<|message|>## 為什麼 OpenAI 會推出「gpt‑oss」這類開源權重模型?

| 推出原因 | 背後的策略 |

|----------|------------|

| **1️⃣ 社群推廣與口碑營造** | - 讓研究人員、學生和業界工程師能夠直接使用、實驗並改進模型,形成一個自發的「使用者社區」<br>- 開放權重可產生大量二次創作(論文、工具、API 等),自然地把 OpenAI 的技術推廣到更多人眼中 |

| **2️⃣ 透明度與信任** | - 大模型在安全性、偏見、濫用等議題上備受關注,開放權重能證明「我真的可以公開這些參數」<br>- 透過社群審視,OpenAI 能更快發現潛在問題並修正 |

| **3️⃣ 測試與優化** | - 在正式商業產品(如 ChatGPT)外,開放模型讓研究人員能在不同硬體、框架上測試性能<br>- 透過社群反饋收集各種使用情境的資料,以改進未來版本 |

| **4️⃣ 法規與政策** | - 一些國家/地區要求 AI 模型必須「可驗證」或「可審計」。開放權重能滿足這類合規需求,避免因封閉模型而被禁止使用。<br>- 也可作為 OpenAI 對政府機構展示其安全承諾的工具 |

| **5️⃣ 生態系統與商業化** | - 透過開源,吸引第三方開發者創造插件、微調版或專門用途(如醫療、法律)<br>- 當這些衍生產品成功後,可將其推向市場,形成「平台+生態」的營收模式 |

| **6️⃣ 競爭對策** | - 大模型領域的競爭激烈。若只保留封閉權重,可能被其他公司「抄襲」或開發類似技術;相反地,開放可讓 OpenAI 成為「基礎研究標準」,把其他公司的研究都建構在其上。 |

| **7️⃣ 人才吸引與保留** | - 開源項目是吸引頂尖研究人員的強大招募工具。若有機會參與開發、改進 GPT‑OSS,對人才來說非常具吸引力。 |

---

## 策略拆解

### 1. **雙向門戶(Open ↔ Closed)**

| 方向 | 內容 |

|------|------|

| **從 Open → Closed** | 社群研究得到的新方法、優化技巧能被快速整合到商業模型中。<br>例如:更高效的微調技術、稀疏注意力、量化策略等。 |

| **從 Closed → Open** | 讓使用者感受「即使不付費也能體驗先進 AI」,降低對商業版的門檻,提升品牌黏著度。 |

### 2. **治理與安全的預演場**

- 開放權重作為「測試平台」:任何人都可以在本地或雲端跑模型,並自行實驗防禦機制(如對抗樣本、輸入過濾)。<br>

- 這不僅能發現漏洞,也能讓 OpenAI 的安全團隊提前評估不同硬體/框架下的風險。

### 3. **政策倡議與公共關係**

- 在 AI 道德、監管討論中,OpenAI 可以以「我們已公開權重」作為案例,證明自己對透明度負責。<br>

- 這有助於在國際規範制定時獲得更多說服力。

### 4. **多元化收入模式**

| 模式 | 實例 |

|------|----------|

| **增值服務** | 對開源模型提供高級微調、部署工具、資料集等。 |

| **平台合作** | 與雲端供應商(AWS, Azure, GCP)合作,將 GPT‑OSS 作為基礎服務提供。 |

| **專案諮詢** | 為企業定制化開發(如客服機器人、翻譯系統)。 |

---

## 可能的風險與應對

1. **濫用風險**

*策略*: 在權重公開時加入「使用者協議」或「倫理標準」,並提供安全審計工具。

2. **知識產權流失**

*策略*: 透過授權(例如 Apache 2.0 + 商業條款)保護核心算法,同時開放權重作為「參考實現」。

3. **競爭對手抄襲**

*策略*: 先把模型公開,再在商業產品中加入專利化的改進;同時保持 API 的封閉,確保核心價值不被完全複製。

---

## 小結

OpenAI 推出 GPT‑OSS 的核心動機是 **“將技術開放、同時打造可持續的生態與商業模式”**。

- **開放** 讓社群快速迭代,提升安全性和透明度;

- **封閉** 仍保留在商業化、合規、核心優化等關鍵領域的優勢。

這種「雙面策略」不僅能鞏固 OpenAI 的市場領先地位,也為 AI 產業的健康發展提供了可參考的模式。

3.4 Ollama:本地部署簡化方案

Ollama 讓 GPT-OSS 的本地部署指令列變得簡單 9,最近也推出了 Ollama App 10 (on macOS, Windows) 多了 app UI。但簡單歸簡單,效能記得比較一下,免得省了安裝時間,卻浪費了電費。

# 一鍵安裝和執行

ollama run gpt-oss:20b

# 或選擇較大模型

ollama run gpt-oss:120b

Ollama 也順勢推出 Ollama Turbo 方案,讓手邊沒有合適機器或是希望簡單代管方案的客戶有所選擇,目前僅支援 OpenAI GPT-OSS 模型。可以想成是簡單版的 Amazon Bedrock。

3.5 AWS 生態系統深度整合

根據 AWS 官方博客 11,OpenAI GPT-OSS 模型於發布當下已全面整合至 AWS 生態系統,為企業提供完整的雲端 AI 解決方案。

3.5.1 Amazon Bedrock 支援

Amazon Bedrock 現已支援 GPT-OSS 模型家族,提供:

技術規格增強:

- 128K context window:GPT-OSS 在 Amazon Bedrock 上支援 128K tokens 的 context window。

- 可調整推理級別:支援 low/medium/high 三種推理強度設定,讓使用者在性能與成本間靈活平衡。

- OpenAI 相容端點:提供與 OpenAI API 完全相容的介面,最小化遷移成本。

3.5.2 SageMaker JumpStart 整合

Amazon SageMaker JumpStart 提供一鍵部署的 GPT-OSS 解決方案:

快速部署:

# SageMaker JumpStart 部署範例

import boto3

from sagemaker.jumpstart.model import JumpStartModel

model = JumpStartModel(

model_id="huggingface-llm-gpt-oss-20b",

role=execution_role,

instance_type="ml.g5.2xlarge"

)

# 一鍵部署到 SageMaker 端點

predictor = model.deploy(

initial_instance_count=1,

accept_eula=True

)

# 呼叫推論

response = predictor.predict({

"inputs": "分析企業數位轉型的關鍵因素",

"parameters": {

"max_new_tokens": 1024,

"temperature": 0.7,

"reasoning_level": "medium" # 可調整推理級別

}

})

AWS 還整合了 Strands Agents 框架 12,這是 AWS 於 2025 年 5 月發布的開源 AI agents 開發套件,支援多種模型提供商(包括 OpenAI、Anthropic、Meta 等)。

3.6 其他企業級整合

3.6.1 Databricks

- 原生整合至 Databricks 平台

- 無縫連接企業資料湖

- 支援大規模批次推論

- 符合企業安全與合規要求

4. 性能基準與比較分析

GPT-OSS 在多項權威基準測試中表現良好,特別是在推理密集型任務上。

4.1 核心性能資料

以下性能資料引用自 OpenAI 官方發布頁面 2 和 Hugging Face 模型頁面 3 7。

推理與學術能力

| 基準測試 | gpt-oss-120b | gpt-oss-20b | o3 | o4-mini | o3-mini | 說明 |

|---|---|---|---|---|---|---|

| MMLU | 90.0% | 85.3% | 93.4% | 93.0% | 87.0% | 多領域語言理解 |

| GPQA Diamond | 80.1% | 71.5% | 83.3% | 81.4% | 77.0% | 研究生級別科學問答(無工具) |

| HLE | 19.0% | 17.3% | 24.9% | 17.7% | 13.4% | Humanity’s Last Exam(有工具) |

數學競賽能力

| 基準測試 | gpt-oss-120b | gpt-oss-20b | o3 | o4-mini | o3-mini | 說明 |

|---|---|---|---|---|---|---|

| AIME 2024 | 96.6% | 96.0% | 95.2% | 98.7% | 87.3% | 數學競賽 2024(有工具) |

| AIME 2025 | 97.9% | 98.7% | 98.4% | 99.5% | 86.5% | 數學競賽 2025(有工具) |

程式設計能力

| 基準測試 | gpt-oss-120b | gpt-oss-20b | o3 | o4-mini | o3-mini | 說明 |

|---|---|---|---|---|---|---|

| Codeforces | 2622 Elo | 2516 Elo | 2706 Elo | 2719 Elo | 2073 Elo | 競程程式設計(有工具) |

專業應用能力

| 基準測試 | gpt-oss-120b | gpt-oss-20b | o3 | o4-mini | o3-mini | 說明 |

|---|---|---|---|---|---|---|

| HealthBench | 57.6% | 42.5% | 59.8% | 50.1% | 37.8% | 真實健康對話場景 |

| Tau-Bench Retail | 67.8% | 54.8% | 70.4% | 65.6% | - | 工具呼叫與函數使用 |

4.2 比較開源模型

| 功能面向 | GPT-OSS | Llama 3.1 | Gemma 3 | DeepSeek-R1 |

|---|---|---|---|---|

| 授權 | Apache 2.0 | Llama Community License (>700M MAU需申請授權) | Google 自訂授權 (允許商用但有使用政策限制) | MIT |

| 推理透明 | 完整 CoT | 無 | 無 | 部分 CoT |

| 工具使用 | 原生支援 | 需要微調 | 原生支援 | 原生支援 |

| 部署生態 | 廣泛支援 | 廣泛支援 | 廣泛支援 | 有限支援 |

| 硬體需求 | 16GB (20B) / 80GB (120B) | 16GB (8B) / 45GB (70B) / 243GB (405B) | 1.5GB (1B) / 6.4GB (4B) / 20GB (12B) / 46GB (27B) | 48GB (70B) / 480GB (671B) |

| 推理能力 | 專門優化推理 | 通用能力 | 通用能力 | 可推理 |

5. 安全性與風險評估

OpenAI 對 GPT-OSS 進行了嚴格的安全評估,這也是開放權重模型領域的重要創新。

5.1 Preparedness Framework

Preparedness Framework 是 OpenAI 內部的災難性風險評估體系,涵蓋四個核心風險類別:

- 網路安全 (Cybersecurity)

- 生化核輻射 (CBRN)

- 說服力 (Persuasion)

- 模型自主性 (Model Autonomy)

每個類別都有「低、中、高、關鍵」四個風險等級,達到「高」等級的模型將不會被部署。

5.2 惡意微調風險測試

對於開放權重模型,惡意微調 (Malicious Fine-tuning) 是一個重要的風險考量。攻擊者可能:

- 使用有害資料對模型進行微調

- 破壞模型的安全護欄機制

- 創造能產生危險內容的模型版本

OpenAI 的測試方法:

- 主動進行「紅隊演練」,模擬攻擊者行為

- 使用專門的生物學和網路安全資料集進行惡意微調

- 評估微調後模型的實際危險能力

測試結果:即使經過專門設計的惡意微調,gpt-oss-120b 也未能達到「高風險」等級,驗證了模型的內在安全性 2。

5.3 使用政策與治理機制

除了 Apache 2.0 授權,GPT-OSS 還搭配了 使用政策 (Usage Policy)。只能防君子(吧)。

6. 實際應用場景解析

基於對 GPT-OSS 技術特性的深度分析,我們可以識別出多個具有高度實用價值的應用場景。

6.1 企業級應用場景

6.1.1 本地資料分析與 BI

場景描述:金融機構需要對敏感的客戶資料進行分析,但不能將資料傳送到外部 API。

GPT-OSS 解決方案:

- 在內網環境部署 gpt-oss-120b

- 使用 Chain-of-Thought 能力進行複雜的財務分析

- 透過工具使用功能直接查詢內部資料庫

- 生成詳細的分析報告和建議

技術優勢:

- 資料不出內網,符合金融業合規要求

- Apache 2.0 授權允許商業使用

- 推理過程透明,便於審計和驗證

6.1.2 客服與支援自動化

場景描述:電商平台需要處理大量客服詢問,特別是複雜的技術問題和退貨流程。

GPT-OSS 解決方案:

# 客服機器人範例

def handle_customer_query(query, customer_context):

# 使用 Harmony 格式進行多步驟推理

reasoning_prompt = f"""

<|start|>role:system

<|message|>

你是專業客服代表,需要:

1. 分析客戶問題的核心需求

2. 查詢相關政策和產品資訊

3. 提供準確且人性化的解決方案

<|end|>

客戶資訊:{customer_context}

問題:{query}

"""

response = gpt_oss_model.generate(reasoning_prompt, tools=["database_query", "policy_lookup"])

return response

6.1.3 程式碼審查與重構

場景描述:軟體開發團隊需要對大型程式碼庫進行品質審查和自動重構。

GPT-OSS 解決方案:

- 分析程式碼結構和設計模式

- 識別潛在的安全漏洞和性能問題

- 建議重構方案並生成改進後的程式碼

- 提供詳細的變更說明和測試建議

6.2 開發者與研究場景

6.2.1 AI 研究與實驗

研究價值:

- 推理機制研究:透過 Chain-of-Thought 分析,研究大模型的推理模式

- 對齊技術開發:基於開放權重進行安全對齊技術的研究

- 微調實驗:探索針對特定領域的微調策略

實驗設定:

# 研究環境設定

git clone https://github.com/openai/gpt-oss

cd gpt-oss

# 載入模型進行推理分析

python research/analyze_reasoning.py \

--model gpt-oss-20b \

--dataset reasoning_benchmark \

--output reasoning_analysis.json

6.2.2 教育與培訓應用

教學場景:

- 程式設計教學:學生可以觀察 AI 的程式設計思維過程

- 邏輯推理訓練:透過 Chain-of-Thought 學習結構化思考

- 多語言學習:利用工具使用能力進行語言實踐

教學優勢:

- 無 API 金鑰限制,適合大規模教學部署

- 推理過程透明,有助於學習理解

- 本地部署確保學習資料隱私

6.2.3 原型開發與 MVP 建構

開發流程:

6.3 新興應用模式

6.3.1 多代理系統協作

GPT-OSS 的工具使用能力使其成為多代理系統中的優秀候選:

class ResearchAgent:

def __init__(self):

self.model = GPTOSS("gpt-oss-20b")

self.tools = ["web_search", "paper_analysis", "data_visualization"]

async def research_topic(self, topic):

# 使用 Chain-of-Thought 制定研究策略

strategy = await self.model.plan_research(topic)

# 並行執行多個研究任務

results = await asyncio.gather(*[

self.search_papers(strategy.keywords),

self.analyze_trends(strategy.time_range),

self.gather_statistics(strategy.data_sources)

])

# 整合研究結果

report = await self.model.synthesize_report(results)

return report

6.3.2 邊緣運算與 IoT 整合

gpt-oss-20b 的 16GB 記憶體需求使其能夠部署在邊緣裝置上:

應用場景:

- 智慧工廠:即時分析生產資料,無需雲端連線

- 智慧城市:本地處理交通和環境資料

- 醫療設備:離線醫學影像分析和診斷建議

技術架構:

邊緣裝置 (32GB RAM) → GPT-OSS-20B → 本地決策

↓

定期批次同步 → 雲端管理系統 → 模型更新

Bottomline

GPT-OSS 不僅僅是 OpenAI 的一次產品發布,更是整個 AI 產業成熟度的演進。當 AI 能力不再是專屬於少數公司,當推理過程變得透明可審計,當部署選擇變得多元化時,我們正在見證 AI 技術從「魔法」變為「工具」的歷史時刻。

對於技術領導者而言,現在的關鍵問題不是「是否要使用 GPT-OSS」,而是「如何最有效地整合 GPT-OSS 到現有的技術棧和工作流程中」。彈性運用封閉模型與開放權重模型、微調和優化組織工作流程,比較有可能在 AI 落地整合累積更多產出。

參考資料 Reference

官方文件

技術文件與指南

- OpenAI Harmony Response Format - OpenAI Cookbook

- How to run gpt-oss with vLLM - OpenAI Cookbook

- How to run gpt-oss with Transformers - OpenAI Cookbook

- How to run gpt-oss locally with Ollama - OpenAI Cookbook

生態系統整合

- Welcome GPT OSS, the new open-source model family from OpenAI! - Hugging Face

- vLLM Now Supports gpt-oss - vLLM Blog

- Introducing OpenAI’s New Open Models on Databricks

- gpt-oss - Ollama Model Library

技術規格與基準

媒體報導與分析

- OpenAI launches two ‘open’ AI reasoning models - TechCrunch

- OpenAI releases a free GPT model that can run on your laptop - The Verge

- OpenAI Just Released Its First Open-Weight Models Since GPT-2 - WIRED

安全性與風險評估

- Safety Risks from Customizing Foundation Models via Fine-tuning - Stanford HAI

- AI Red Teaming Best Practices - HiddenLayer

技術背景與相關研究

- Switch Transformer: Scaling to Trillion Parameter Models - Google Research

- [1701.06538] Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer

- Introducing NVFP4 for Efficient and Accurate Low-Precision Inference - NVIDIA

- Efficient Memory Management for Large Language Model Serving with PagedAttention - vLLM